红外弱小目标检测技术应用广泛,在海洋资源保护、精确制导、无人驾驶、自然资源勘探等军民领域得到了广泛的应用。近年来,随着深度学习技术的发展,红外弱小目标检测领域发展迅猛,各科研团体在空基、陆基、天基等公开数据集上不断突破,争相夺得领域新高度。随着红外检测的迅猛发展,其瓶颈也逐渐凸显。以学术论文为导向的发展方向越来越难以满足重大应用需求,模型设计日趋复杂、跨域泛化适应能力不足等问题在制约领域进一步发展的同时,也限制了工程应用价值,领域发展亟需新的增长引擎。

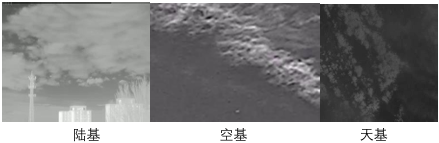

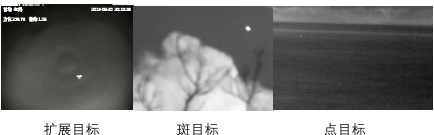

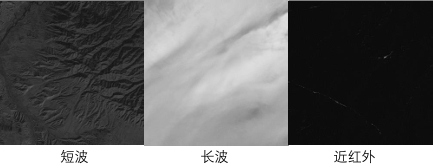

近年来,随着以生成式聊天大模型ChatGPT和视觉分割一切模型SAM为代表的大模型技术的爆火, 具备解决空天地一体化的广域红外弱小目标检测领域大模型呼之欲出。领域普遍认为, 未来的红外弱小目标检测大模型具备以下能力: 1. 多种观测视角下的一体化检测能力(如陆基、空基、天基); 2. 多种目标类型下的一体化检测能力(如点目标、斑目标、扩展目标); 3. 多种红外波段的一体化检测能力(如近红外、短波红外、长波红外); 4. 多种图像分辨率的一体化检测能力(如512×512、10000×10000); 5. 多种数据分布的泛化适应能力。

因此,我们组织广域红外小目标检测挑战赛,希望与国内各优势单位形成合力,进一步提升现有算法的性能极限和泛化适应能力,为后续空天一体化地大模型孵化和领域持续发展注入活力。

本次挑战赛主要任务是对红外小目标图像进行分割,参赛队伍根据红外小目标图像特点自行设计相关的算法,利用主办方所给的红外小目标图像数据集进行模型训练,最终以交并比(Intersection Over Union, IoU)、检测概率(Probability of Detection, Pd)和虚警概率(False Alarm, Fa)作为评价指标衡量参赛队伍算法模型性能。

| 数据类型 | 数据内容 |

|---|---|

| 多观测视角 |  |

| 多目标类型 |  |

| 多波段 |  |

| 多分辨率 |  |

本次挑战赛的算法评价指标为交并比(Intersection Over Union, IoU)和检测概率(Probability of Detection, Pd), 其中,IoU指标的具体定义如下:

像素级评价指标交并比(Intersection Over Union, IoU)定义为预测掩码和标签掩码之间的交集区域与并集区域之比,其公式定义如下: $$ I o U = A _ { i n t e r } / A _ { u n i o n }$$

其中\(A _ { i n t e r }\)和\(A _ { u n i o n }\)为交集区域与并集区域的像素数量。

目标级评价指标检测概率定义为正确检测的目标数量与目标总数量之比,虚警率定义为虚警数量与图像总像素数之比,其公式定义如下: $$ \begin{matrix} P d = T D / A T \\ F a = F D / N P \end{matrix}$$

其中Pd和Fa分别为检测概率和虚警概率,TD(True Detection)和 FD(False Detection)分别为正确检测的目标数量和虚警数量,AT(Amount of Target)和 NP(Number of Pixels)分别为真实目标总数量和图像总像素数。如果目标的质心偏差小于预先定义的偏差阈值Thresh,则认为这些目标是正确预测的目标。如果目标的质心偏差大于预定义的偏差阈值Thresh,我们将这些像素视为错误预测的像素。预定义的偏差阈值Thresh设为3。

算法的最终评分采用IoU与Pd的线性加权和,其对应的分数S定义如下: $$ S = \alpha * I o U + ( 1 - \alpha ) P d$$

注意,虚警概率Fa必须低于γ才记为有效成绩,否则成绩无效,仅公布IoU、Pd、Fa的具体得分,但是不计入排名。

注意:γ = 2e-5, \(\alpha\) = 0.5

长沙景嘉微电子股份有限公司赞助商将提供1台国产GPU服务器负责对参赛团队提交的算法模型进行验证与系统测试。

| CPU | Intel(R) Xeon(R) W-2123 CPU @ 3.60GHz |

| GPU | 景嘉微 景宏1号 JH100P-64G |

| 内存 | 32G |

| 操作系统 | Ubuntu |

1. 参赛队伍须提供算法模型代码和对应的Docker镜像文件(可使用主办方公开的Docker镜像文件),算法模型代码用于主办方在测试集上对算法模型性能进行测试。

2. 每个队伍最多可提交四次结果,取最后一次结果作为最终结果,结果及排名将在本赛事网页上实时更新。若代码不能正常运行,则提交内容视为无效提交,不计入提交次数。

3. 为了避免参赛队伍滥用其他数据集或验证集标签信息用于算法训练,参赛队伍需提供算法训练时的相关参数,要求该算法结果可复现。如果发现参赛队伍使用其他数据信息用于训练或算法结果无法复现,视为作弊处理,取消参赛资格。

4. 系统只支持Python代码和Pytorch深度学习框架。

注意:比赛中不允许使用额外数据,或者预训练模型。

组委会将举办挑战赛技术论坛,邀请获得一、二等奖的参赛队伍参加作特邀技术报告。

1. 参赛团队提交算法及可执行模型的知识产权归参赛团队所有,图像数据中公开数据部分由各数据集作者所有,主办方自建数据归主办方所有。

2. 各参赛队在赛前需签订数据使用协议,承诺本挑战赛提供的数据集仅能用于本挑战赛,不用于除本挑战赛外的任何其他用途。

3. 各参赛队需要承诺本队提交的结果可重复,组织方承诺履行保密义务,并不用于除本比赛外的任何其他用途。

4. 参赛队伍应保证所提供的方案、算法属于自有知识产权。组织方对参赛队伍因使用本队提供完成的算法和结果而产生的任何实际侵权或者被任何第三方指控侵权概不负责。一旦上述情况和事件发生参赛队伍必须承担一切相关法律责任和经济赔偿责任并保护组织方免于承担该等责任。